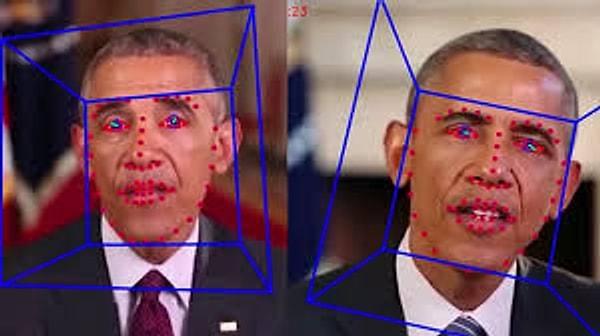

Deepfake Tehlikesi: Basit Bir Telefon Uygulaması Suratınızı Kopyaladığı İçin İşlemediğiniz Bir Suçtan Hapse Girebilirsiniz!

İşler karışıyor, eğer tehlikeyi göremiyorsak artık kendi suratımızı hiç istemediğimiz bir yerde görürsek şaşırmayalım. 😱

Deepfake, önümüzdeki yılların en büyük gündemi olmaya aday ve tahminlerinizin ötesinde sonuçları olacak gibi görünüyor.

Yani eğlence için suratlarını bir yerlere monte eden insanlardan bahsedilse de bu tip teknolojilerin kötü amaçlarla kullanıldığında yıkıcı sonuçlar yaratabileceğini hepimiz biliyoruz. Yakın zamana dek bu görüntüleri oluşturmak için bilgisayar kullanmak, birkaç uygulamaya hakim olmak gerekiyordu.

Geçtiğimiz günlerde kullanılmaya başlanan bir uygulama hayli ilginç değişimlerin şafağında olduğumuzu düşündürmeye başladı.

Çin'de yayınlanan ZAO isimli uygulama, birkaç saniyede sizin yüzünüzü filmlerde yer alan herhangi bir sahneye uyarlıyor.

Görüntülerin hangi açıda olduğu yahut yüz yapı farklarının hiçbir önemi yok. Uygulama öylesine basit şekilde sizin mimiklerinizi ve yüz yapınızı kopyalıyor ki herhangi birinin yüzüne bu kalıp çok rahat uygulanabiliyor.

Örneğin bu, bir kullanıcının kendi yüzüyle meşhur filmlere yaptığı birkaç montaj...

Çin'in FaceApp'i olarak geçiyor olsa da uygulama FaceApp gibi salt eğlence için ortada değil. Deepfake teknolojisinin cep telefonlarında kullanılacak kadar basit algoritmalarla çalıştığının bir ispatı ve bu noktadan sonra düşünmemiz gereken şeyler var, çünkü sadece görüntüyle de sınırlı kalmıyor Deepfake.

İşin içine seslerimiz de girdi.

İnsanların seslerini taklit edebilen yapay zeka uygulamaları gün yüzüne çıkıyor, hem de çok büyük yıkımlar yaratarak.

Geçtiğimiz aylarda bir şirket yöneticisinin sesini taklit eden algoritma ile $243,000 dolar çalındı ve yöneticinin ağır bir Alman aksanı, hayli dikkat çekici bir ses tonu vardı. Algoritma hiçbir şüphe uyandırmayacak biçimde bu detayları taklit ederek hırsızların istediği şeyleri yöneticinin ağzından söyletebildi.

Ortada kişi yahut kişiler olmadığı, tanımlanabilecek bir yabancı kimliği de olmadığı için hiçbir ipucu da yok, yani şirket çaresiz!

Şimdi, sıra Deepfake'in herkes tarafından kullanılabilmesinin yaratacağı risklere geldi...

Bir gün sizin sesinizi taklit eden bir kişi sizin adınıza ailenize ulaşıyor ve tahmin edemeyeceğiniz taleplerde bulunuyor yahut sizin yüzünüzün yerleştirildiği bir görüntü internet alemlerinde dolaşıyor ve size kimse inanmıyor...

İş artık sadece eğlence değil, böylesine hızlı yayılan bir teknolojiyle başkalarının görüntüleri, sesleri sizin yerinize geçebilir. Bir gün sizi sevmeyen biri tarafından işinizden kovulacak sözler söylemiş olarak bulunabilirsiniz yahut işlemediğiniz bir suç için hapse girebilirsiniz...

Yakında bir hukuki düzenleme gelir mi bilinmez fakat gidişat bizi hayli ürkütmeye başladı.

Fakat soru halen baki: Kullanan insanlık kötü niyetli olduktan sonra deepfake'i nasıl suçlayabiliriz ki?

Keşfet ile ziyaret ettiğin tüm kategorileri tek akışta gör!

Yorum Yazın